Sieci LAN

Niezbędny sprzęt sieciowy

Serwery, stacje robocze, karty sieciowe i kable to sprzętowy szkielet sieci, który wraz z oprogramowaniem sieciowym i użytkowym tworzy pełny zestaw. Ponieważ współczesne produkty sprzętowe są zgodne z międzynarodowymi standardami, w tej samej sieci można wykorzystywać sprzęt różnych producentów. Zakupiony sprzęt nie ogranicza wyboru oprogramowania, jakie będzie można używać w sieci. Jednak zakup odpowiedniego sprzętu nie jest prosty. Już na samym początku trzeba podjąć decyzje, których skutki będą odczuwalne w długim okresie.

Serwery i klienci

W sieciach lokalnych komputery mogą pełnić rolę serwerów lub stacji klienckich. Serwery udostępniają swoje zasoby, którymi są napędy dysków, drukarki, modemy, łącza komunikacyjne (dostęp do Internetu, możliwości nadawania i odbioru faksów), stacjom klienckim.

Oprogramowanie działające na stacjach klienckich umożliwia użytkownikom sieci korzystanie z danych i urządzeń dostępnych na przynajmniej jednym serwerze. Typ oprogramowania sieciowego działającego na serwerze decyduje, czy jest on dedykowany do pełnienia roli serwera, czy też możliwe jest uruchamianie na nim lokalnego oprogramowania. W zasadzie w sieci typu równy-z-równym (peer-to-peer) komputer może być jednocześnie serwerem dla innych klientów i klientem dla innych serwerów.

W praktyce dowolny komputer z procesorem klasy Pentium może działać jako serwer plików w biurowej sieci liczącej do pięćdziesięciu stanowisk. Nawet komputery z procesorami 80386 i 80486 nadają się do roli serwerów wydruków i serwerów faksów. Jednak niektóre aplikacje działają częściowo na serwerze, więc zainwestowanie w wydajny procesor będzie procentować w przyszłości. W przypadku aplikacji biznesowych, obsługujących gospodarkę materiałową, systemy rezerwacji, księgowość, proces projektowania serwera wykracza poza rutynowe rzemiosło. Najlepiej skorzystać z doświadczeń firmy sprzedającej zaawansowane aplikacje, aby uzyskać wytyczne dotyczące odpowiednich parametrów serwera.

Wiele firm sprzedaje jako serwery komputery z wieloma gniazdami rozszerzeń i wnękami na napędy dysków. Ale nie zawsze najlepszym serwerem jest komputer z szybkim procesorem w obudowie szafkowej. Oto w pigułce podane porady dotyczące serwera: szybkie napędy dysków i dużo pamięci RAM. Najpierw należy wybrać dobry dysk twardy z pojemnością trzykrotnie przekraczającą przewidywane zapotrzebowanie. Dawniej Autor zalecał wykorzystanie sterownika dysku twardego z interfejsem SCSI (Small Computer Systems Interfejs) z uwagi na szybkość obsługi danych. Również dzisiaj szybkie kontrolery SCSI-2 z własną pamięcią podręczną i procesorem zwiększają wydajność zaawansowanych serwerów korporacyjnych w warunkach dużego obciążenia. Jednak obecnie wiele firm uważa, że nowe dyski standardu IDE o dużej pojemności są wystarczająco wydajne do tych zastosowań, a cenowo są bardziej atrakcyjne od dysków SCSI.

Jeśli podstawowym czynnikiem jest niezawodność sieci, zapewne warto będzie wydać więcej pieniędzy na macierz dysków RAID. Skrót ten pochodzi od nazwy Redundant Array of Inexpensive Disks (Nadmiarowa macierz tanich dysków). Idea tego urządzenia opiera się na połączeniu maksymalnie pięciu dysków w jeden system, w którym dane zapisywane są na wszystkich dyskach.

Przeplatanie (striping) danych na różnych dyskach jest korzystne pod względem wydajności i niezawodności. Ponieważ głowice poszczególnych napędów nie muszą poruszać się tak szybko operacjie zapisu i odczytu, są realizowane szybciej niż w pojedynczym napędzie. W macierzach klasy RAID 5 wykorzystuje się funkcję nazywaną kontrolą parzystości. Podczas awarii pojedynczego dysku w takiej macierzy, kontroler – na podstawie informacji o parzystości i zawartości pozostałych dysków, jest w stanie odtworzyć zawartość uszkodzonego dysku. Macierze RAID 5 są jednym z głównych elementów tak zwanych serwerów o wysokiej dostępności.

Karty sieciowe

Najczęstszą inwestycją w sprzęt dla sieci LAN jest zakup kart sieciowych (zwanych ogólnie kartami interfejsu sieciowego lub adapterami sieciowymi). W roku 1987 typowa karta sieciowa kosztowała 600 USD. Jednak postęp technologii elektronicznych obwodów drukowanych sprawił, że obecnie karty sieciowe są produktem powszechnie dostępnym. Dzisiaj karty bez „wodotrysków” można kupić za około 200 zł, a najprostsze modele dla sieci o prędkości 10 Mb/s kosztują poniżej 100 zł.

Każdy komputer w sieci musi być wyposażony w kartę sieciową, która przekształci sygnały szeregowe z kabla sieciowego w strumień danych równoległych wewnątrz komputera.

Karty te również wzmacniają sygnały, tak aby mogły one przebyć żądany dystans. W niektórych przypadkach w serwerze można zainstalować dwie i więcej kart sieciowych, aby podzielić obciążenie na odrębne kable sieciowe i zmniejszyć ryzyko przeciążenia sieci. Ważnym zadaniem adapterów sieciowych jest również sterowanie dostępem do nośnika. Funkcje sterowania dostępem do nośnika (Media Access Control – MAC) realizowane są na jeden z trzech sposobów: nasłuch przed transmisją, numer kolejny stacji i przekazywanie żetonu.

Kilometry drutu i ani centymetra łącza

Najpoważniejszą kwestią związaną z wyborem karty sieciowej jest rodzaj kabli, czyli przewodów elektrycznych, jaki ma być używany w sieci. Współczesne karty dla sieci Ethernet i Token-Ring umożliwiają szeroki wybór różnych typów okablowania. Należy jednak pamiętać, że sieć nie będzie ani odrobinę lepsza niż zastosowane okablowanie. Okablowanie wiąże ze sobą wszystkie elementy sieci i jeśli zostanie zainstalowane nieprawidłowo, będzie pewną przyczyną frustracji i niepowodzeń.

Wybór kart sieciowych jest zatem określony przez rodzaj okablowania, jaki ma być wykorzystany do połączenia serwerów i stacji klienckich. Do wyboru jest kabel koncentryczny, kabel światłowodowy, skrętka nieekranowana i ekranowana. Jeśli w danym budynku jest już zainstalowane okablowanie, trzeba dobrać karty sieciowe, tak aby mogły z nim współpracować.

Prawidłowe działanie sieci jest zagrożone przez takie zjawiska elektryczne jak przesłuchy i zewnętrzne zakłócenia elektryczne. Przesłuchy pojawiają się wówczas, gdy pole elektryczne wokół jednego przewodu powoduje generowanie fałszywych sygnałów elektrycznych w sąsiednim przewodzie. Z kolei źródłem zewnętrznych zakłóceń elektrycznych mogą być źródła światła, silniki elektryczne, urządzenia radiowe i wiele innych urządzeń. Niekorzystny wpływ przesłuchów i zakłóceń rośnie wraz ze wzrostem prędkości transmisji sygnałów w sieci. Dlatego nadrzędnym celem każdego systemu okablowania jest utrzymanie minimalnego poziomu przesłuchów i zakłóceń zewnętrznych.

Kabel koncentryczny

Kabel koncentryczny stanowi dobre zabezpieczenie przed przesłuchami i zakłóceniami zewnętrznymi. Utkany z metalu lub folii aluminiowej oplot otacza z zewnątrz pojedynczy przewód miedziany, stanowiąc poważną barierę dla zakłóceń elektrycznych. Pierwotnie w instalacjach sieci Ethernet i ARCnet używany był niemal wyłącznie kabel koncentryczny.

W jednej z odmian Ethernetu wykorzystywano gruby kabel koncentryczny – szczególnie jako połączenie szkieletowe pomiędzy budynkami i pomiędzy poszczególnymi kondygnacjami budynku. Jednak instalacja kabla dla Grubego Ethernetu jest trudna. Na próżno go szukać w nowych instalacjach, ale 5-10 lat temu był często stosowany. Teoretyczna żywotność takich instalacji jest określana w dziesiątkach lat.

Ponieważ kabel koncentryczny jest droższy i zajmuje więcej miejsca w kanałach kablowych, został on wyparty przez nieekranowaną skrętkę dla połączeń wewnątrz budynków i kable światłowodowe w połączeniach o większym zasięgu.

Kable swiatlowodowe

Kable światłowodowe pozwalają łączyć ze sobą stacje pozostające w większej odległości; łącze tego rodzaju może mieć zasięg kilku kilometrów i nie wymaga instalowania wtórników (repeater), które regenerowałyby sygnały.

Ponadto światłowód jest zupełnie odporny na zakłócenia elektryczne (w omawianych zastosowaniach również nie występuje problem przesłuchów – przyp. tłum.).

Nadajniki radiowe, spawarki elektryczne, świetlówki i inne źródła zakłóceń elektrycznych nie mają żadnego wpływu na impulsy świetlne przesyłane wewnątrz kabla tego rodzaju. Wielu dostawców oferuje wersje kart sieciowych dostosowane do transmisji światłowodowej.

Jednak okablowanie światłowodowe jest drogie. Zależnie od lokalnych stawek roboczogodzin i warunków technicznych w budynku, instalacja tego rodzaju może kosztować około 200 USD w przeliczeniu na węzeł sieci. Początkowo myślano, że światłowody zastąpią przewody miedziane, przynajmniej w wysoko obciążonych zastosowaniach komercyjnych. Jednak postęp w technologii systemów kablowych, w szczególności możliwość szybkiej transmisji danych poprzez nieekranowaną skrętkę dwużyłową, zmniejszył techniczną przewagę światłowodów.

Skrętka nieekranowana

Skrętka nieekranowana (Unshielded Twisted Pair – UTP) może spełnić wszelkie wymagania w zakresie okablowania sieciowego. Szereg organizacji – w tym Electronic Industry Association, Telecommunications Industry Association (EIA/TIA) i Underwriter’s Loboratories (UL) – opracowało standardy okablowania za pomocą kabla UTP.

Standardy EIA/TIA 586 opisują schematy okablowania strukturalnego z użyciem UTP, które są w stanie obsłużyć najszybsze dostępne połączenia sieciowe pomiędzy stacjami roboczymi. Niektóre połączenia z serwerem mogą wykorzystywać nowszą technologię, nazywaną Gigabit Ethernet, która wymaga okablowania światłowodowego. Jednak głównym jej zastosowaniem są szkieletowe sieci kampusowe.

Skrętka ekranowana

Skrętka ekranowana (Shielded Twisted Pair – STP) pomimo nazwy podobnej do skrętki nieekranowanej, budowę ma odmienną. Wiązka skręconych ze sobą parami przewodów jest tutaj otoczona zewnętrznym ekranem z folii aluminiowej lub oplotu miedzianego, którego zadaniem jest redukcja wpływu zewnętrznych zakłóceń elektrycznych. Różne firmy wykorzystują własne specyfikacje dla kabli tego rodzaju, chociaż standardy IEEE mają zastosowanie do systemów takich jak Token-Ring firmy IBM.

Kable z ekranowanej skrętki są drogie i kłopotliwe w instalacji. Niektóre, jak na przykład firmy IBM dla sieci Token-Ring, są bardzo grube i szybko wypełniają kanały kablowe.

Topologia sieci

Fachowy termin na dzisiaj to topologia. Zarówno w sieciach komputerowych, jak i w języku potocznym termin ten oznacza „kształt rzeczy”. Topologia fizyczna opisuje przebieg kabli sieciowych łączących poszczególne węzły, topologia logiczna natomiast opisuje przepływ komunikatów pomiędzy stacjami sieciowymi. Układ fizyczny wcale nie musi odpowiadać ścieżkom logicznym.

W sieci ARCnet używa się zwykle schematu okablowania, czyli topologii, w którym każda stacja jest połączona bezpośrednio z centralnym koncentratorem (tak zwana topologia gwiazdy – przyp. tłum.), co redukuje zagrożenie dla działania sieci w przypadku awarii pojedynczego łącza. Podobny koncentrator występuje w topologii sieci Token-Ring (sieć Token-Ring jest przykładem topologii pierścieniowo-gwiaździstej – przyp. tłum.).

Starsze sieci w standardzie Cienki Ethernet budowane były na zasadzie szeregowego łączenia stacji sieciowych (topologia magistrali – przyp. tłum.), co było ekonomiczne, jeśli wziąć pod uwagę ilość potrzebnego kabla. Jednak takie rozwiązanie rodziło ryzyko całkowitej awarii sieci w przypadku uszkodzenia któregokolwiek połączenia. Z powodu tej wady, współczesne sieci w standardzie Ethernet buduje się w topologii gwiazdy, jednak wciąż działa wiele szeregowych instalacji opartych na Cienkim Ethernecie. Fizyczna struktura sieci lokalnej obejmuje wiele elementów: karty sieciowe, koncentratory, okablowanie, serwery wydruków, serwery plików i inne współpracujące ze sobą urządzenia.

Oprogramowanie

Dzięki obecnym standardom i protokołom liczba kombinacji poszczególnych elementów sieciowych (serwerów, kart sieciowych, kabli i oprogramowania) jest niemal nieograniczona. Pozwala to zbudować sieć optymalną pod względem wydajności i ekonomiki.

Wiele osób bardziej martwi się o kable i karty sieciowe niż o sieciowe systemy operacyjne. O ile wiedzą oni zwykle, że potrzebują serwera z szybkimi dyskami i szybkim procesorem, to jednak nie potrafią opisać swych potrzeb dotyczących oprogramowania sieciowego. A przecież to oprogramowanie umożliwia pracę w sieci z pełną wydajnością.

To za sprawą sieciowych systemów operacyjnych można korzystać z odległych zasobów, tak jak z lokalnych. Oprogramowanie sieciowe niweluje różnicę w dostępie do plików na dysku lokalnym i na dysku komputera znajdującego się piętro niżej. Dzięki niemu można drukować na drukarce oddalonej od komputera o kilkaset metrów – a nawet o kilka tysięcy kilometrów – tak, jakby była ona podłączona do portu równoległego naszego komputera. Podobnie można korzystać z sieciowych modemów i innych urządzeń komunikacyjnych, jak gdyby były one podłączone do lokalnego portu szeregowego komputera.

Architektura sieciowych systemów operacyjnych cechuje się wielozadaniowością i wielodostępnością. System operacyjny komputera biurkowego odbiera po kolei żądania od programów użytkowych i tłumaczy je na czynności, które mają być wykonane przez monitor, napęd dysków i inne urządzenia peryferyjne. Natomiast sieciowe systemy operacyjne odbierają żądania usług od wielu programów użytkowych jednocześnie i realizują je za pomocą zasobów sieciowych, efektywnie świadcząc te same usługi dla różnych użytkowników.

Niewidzialne i modulowe

Idealne oprogramowanie sieciowe powinno być niewidoczne dla użytkownika. Powinno ono udostępniać dodatkowe zasoby bez konieczności interesowania się, gdzie się one znajdują i jak są przyłączone.

Od strony strukturalnej oprogramowanie sieciowe dzieli się na wiele modułów. Większość z nich znajduje się na maszynie, która działa jako serwer danych, drukarek lub zasobów komunikacyjnych.

Do działania sieci LAN potrzebnych jest kilka dodatkowych elementów sprzętowych (karty i kable sieciowe) i programowych (readresatory, oprogramowanie warstwy sieci i sterowniki).

Programy użytkowe działające na stacjach roboczych mogą mieć wbudowane pewne atrybuty sieciowe, na przykład automatyczną blokadę rekordów lub plików. Jednak te funkcje oprogramowania nie są konieczne, ponieważ nawet te aplikacje, które nie były projektowane do pracy w sieci, mogą być w sieci używane.

Moduł readresatora (redirector) pełni rolę pośrednika pomiędzy programami użytkowymi i systemem operacyjnym stacji roboczej, takim jak DOS, Windows lub UNIX. Jego zadaniem jest przechwytywanie wysyłanych przez oprogramowanie pewnych poleceń dla systemu operacyjnego, na przykład – dostępu do plików. Każdy readresator dla komputera PC jest zaprogramowany tak, aby kierować wywołaniem niektórych zadań poprzez sieć (na przykład żądaniem danych, które znajdują się na dysku niepodłączonym do lokalnego komputera).

Dzięki readresatorowi aplikacje PC mogą łatwo skorzystać z zasobów sieciowych, adresując odpowiedni napęd dysków.

Inny moduł oprogramowania – sterownik karty sieciowej – przesyła dane pomiędzy readresatorem a kartą sieciową klienta PC. Sterownik ten jest napisany specjalnie do obsługi karty sieciowej danego typu. Wielu producentów poprzez współpracę z Microsoftem zapewniło sobie, że sterowniki do ich kart sieciowych są dostępne w systemie operacyjnym Windows. Inni natomiast dołączają do karty sieciowej dyskietkę lub dysk CD ze sterownikami. Najnowsze wersje sterowników można z reguły znaleźć na stronach WWW producentów.

Karta sieciowa jest umieszczana w gnieździe rozszerzeń stacji roboczej. We współczesnych sieciach okablowanie i protokół dostępu do nośnika są zwykle niezależne od oprogramowania sieciowego. Karty sieciowe w swoich pamięciach tylko-do-odczytu zawierają programy, które zarządzają tworzeniem i transmisją pakietów danych w sieci.

Na końcu kabla podłączonego do interfejsu stacji roboczej znajduje się serwer z dodatkowym, specjalizowanym oprogramowaniem dla sieci LAN i własną kartą sieciową. Tak jak na każdym innym komputerze na serwerze działa system operacyjny. Czasami jest to Windows 95 lub 98, ale częściej bywa nim bardziej wydajny wielozadaniowy sieciowy system operacyjny w rodzaju Windows NT Server, Windows 2000, niektóre wersje NetWare Novella lub Solaris Suna. W niektórych sieciach możliwe jest uruchamianie programów użytkowych na serwerze i korzystanie z nich w trybie terminala sieciowego. Poza tym na serwerze działają sieciowe programy narzędziowe, umożliwiające buforowanie wydruków, kontrolę i inne funkcje sieci LAN.

Współpracując ze sobą, moduły programowe realizują podstawowe czynności oprogramowania sieciowego. Krotko mówiąc – oprogramowanie sieciowe rozpoznaje użytkowników, wiąże z ich identyfikatorami przydzielone wcześniej uprawnienia i przez odpowiedni serwer kieruje ich żądania do realizacji.

Cechy systemów operacyjnych

Wybierając konkretny system operacyjny, trzeba wziąć pod uwagę następujące cechy:

Serwery dedykowane kontra rozwiązania współużytkowania. Systemy operacyjne Windows 95/98 umożliwiają każdemu komputerowi w sieci dostęp do dysków, drukarek i innych zasobów.

Te same możliwości mają systemy Windows 2000 i Windows NT. Inne systemy operacyjne, takie jak Novell NetWare i Banyan VINES (system już nieprodukowany, a firma zmieniła nazwę i profil – przyp. tłum.) wymagają dedykowanego serwera.

Rozwiązania współużytkowania zasobów (nazywane również równorzędnym współużytkowaniem zasobów) pociągają zwłaszcza w małych instalacjach, gdzie koszt dedykowanego serwera jest znaczący. Współużytkowanie zasobów stacji roboczej zawsze spowalnia działanie aplikacji lokalnych, podczas gdy w przypadku serwera dedykowanego, wydajność sieci jest znacznie większa. Jednak wiele komputerów PC z procesorem Pentium ma dość mocy, aby obsłużyć lokalne zadania przetwarzania i zadania serwera.

Odporność na awarie. Jeśli w sieci realizowane są operacje o znaczeniu krytycznym dla firmy lub systemu bezpieczeństwa, system operacyjny może zwiększyć możliwość ich pomyślnej realizacji. Tak zwane odporne na awarie systemy operacyjne prowadzą lustrzany zapis operacji dyskowych lub nawet utrzymują powieloną konfigurację całego serwera. W przypadku awarii dysku lub serwera, działanie przejmuje kopia lustrzana. NetWare i Windows NT udostępniają szereg opcji podnoszących odporność systemu na awarie.

Aplikacje wykonywane na serwerze. W typowych sieciach komputerów PC programy użytkowe wykonywane są na stacjach roboczych, a na serwerach działają tylko programy obsługujące system zabezpieczeń i współużytkowanie zasobów. Taka organizacja przeważnie spełnia swoje zadanie, jednak niektóre zadania intensywnie korzystające z dysku efektywniej jest wykonywać na serwerze (dotyczy to na przykład indeksowania bazy danych lub kompilowania kodu źródłowego programu). Wszystkie współczesne sieciowe systemy operacyjne mogą uruchamiać określone zadania aplikacyjne na serwerze, zwiększając efektywność (i złożoność) operacji w przypadku systemów, które łatwo przeciążyć intensywnym użyciem dysku.

Pamięć serwera. Pamięć RAM w serwerze wykonuje ważne zadania, takie jak buforowanie danych pomiędzy kartą sieciową a dyskiem oraz wczytywanie bloków danych z dysku do pamięci podręcznej, tak aby były one szybciej dostępne. 128 MB powinno wystarczyć dla typowego serwera, chociaż 256 MB da lepsze osiągi.

Zarządzanie siecią. Każda sieć do prawidłowego działania potrzebuje osoby, która będzie oficjalnie działać jako administrator systemu.Trzeba się zastanowić na wyborem programów narzędziowych, które umożliwią administratorowi sporządzanie raportów dotyczących tego, kto korzysta z sieci i monitorowanie jej obciążenia. Narzędzia te są istotne z punktu widzenia poprawy wydajności i kosztów kontroli.

Narzędzia diagnostyczne. Niektóre sieciowe systemy operacyjne posiadają programy narzędziowe, których można użyć do diagnozowania problemów i konfigurowania optymalnego działania serwera. Programy te udostępniają informacje o błędnych pakietach i błędach w sieci, a także mogą obejmować narzędzia do obsługi współpracy dysku z pamięcią podręczną.

Bezpieczeństwo. Podstawą systemu zabezpieczeń są zwykle hasła użytkowników. W najlepszych systemach istnieją różne poziomy dostępu i różne uprawnienia użytkowników (w tym do odczytu, zapisu, modyfikacji, tworzenia i zmiany). Inne elementy zabezpieczeń to ochrona hasłem zasobów, na przykład napędów dysków, podkatalogów lub nawet poszczególnych plików, a także możliwość kontroli dostępu na podstawie godziny i dnia tygodnia.

Poczta elektroniczna. Już tylko dobry system poczty elektronicznej może uzasadnić inwestycje w budowę sieci LAN. Jednak proste do niedawna systemy pocztowe, które koncentrowały się na przechowywaniu i przesyłaniu wiadomości ewoluowały w systemy rozpowszechniania komunikatów. Systemy takie udostępniają architekturę, która umożliwia wielu rodzajom programów użytkowych identyfikować użytkowników w sieci i przesyłać informację pomiędzy programami. Systemy rozpowszechniania komunikatów, zapoczątkowane przez interfejs MAPI (Messaging Application Program Interface) Microsoftu, mogą realizować przydatne zadania, w rodzaju automatycznego zapisywania wiadomości głosowej w pliku dźwiękowym i przesyłania go pocztą elektroniczną.

Buforowanie drukowania. Kiedy kilka stacji sieciowych korzysta z drukarki podłączonej do centralnego serwera, zadania drukowania są zapisywane w specjalnym pliku zwanym buforem wydruków (spool). Następnie zadania te są ustawiane w kolejkę do drukarki. Każdy użytkownik powinien mieć możliwość sprawdzenia pozycji swojego zadania w kolejce i usunięcia zadań wysłanych omyłkowo. Administrator sieci powinien mieć możliwość zmiany priorytetu zadań w kolejce wydruków i przypisywania priorytetów pewnym użytkownikom.

Skróty i terminy związane z siecią

Zanim będzie można mówić o pełnym zrozumieniu zagadnień związanych z sieciami, trzeba nauczyć się języka sieci. Przynajmniej kiedy szef zapyta następnym razem, co sądzimy o migracji firmy do SAA, będziemy wiedzieć, że nie chodzi mu o przeniesienie siedziby firmy w rejon anomalii południowo-atlantyckiej (South Atlantic Anomaly). Poniższy przewodnik powinien pomóc rozszyfrować skróty i terminy fachowe, którymi tak gładko posługują się ludzie z branży.

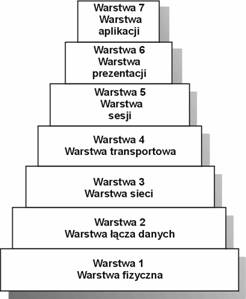

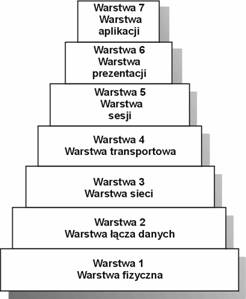

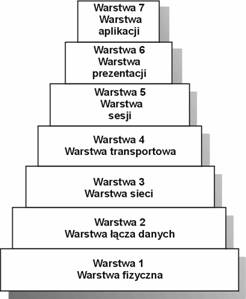

Model OSI opracowany przez ISO

Ponieważ dobrze jest mieć pewną strukturę, do której można przypisać skróty i terminy, na początek zostanie wprowadzone pojęcie modelu OSI opracowanego przez ISO. Międzynarodowa Organizacja Normalizacyjna (International Standards Organization – ISO) z siedzibą w Genewie zajmuje się tworzeniem standardów, między innymi na potrzeby międzynarodowej i narodowej transmisji danych. Amerykańskim przedstawicielem ISO jest Instytut ANSI (American National Standards Institute). Na początku lat siedemdziesiątych organizacja ISO opracowała standardowy model systemów komunikacji danych i nazwała go modelem Współdziałania systemów otwartych (Open Systems Interconnection – OSI).

Model OSI składa się z siedmiu warstw, opisujących procesy zachodzące podczas połączenia terminala z komputerem lub komputera z innym komputerem. Model ten został opracowany z myślą o ułatwieniu budowy systemów, w których mogłyby ze sobą współpracować urządzenia pochodzące od różnych producentów.

Inne modele systemów transmisji danych to SNA (Systems Network Architecture) IBM oraz DNA (Digital Network Architecture) firmy Digital Equipment Corporation, które powstały jeszcze przed modelem OSI.

Przekladaniec OSI

A oto warstwy modelu OSI:

7) Warstwa aplikacji. Na tym poziomie oprogramowanie jest zgodne z obowiązującymi standardami stylu obsługi.

6) Warstwa prezentacji. W tej warstwie dane są formatowane do wyświetlania oraz na potrzeby określonego sprzętu.

5) Warstwa sesji. Warstwa ta określa standardowe metody przesyłania danych pomiędzy aplikacjami.

4) Warstwa transportowa. Oprogramowanie tej warstwy jest szczególnie ważne w sieciach lokalnych. Odpowiada ono za niezawodny transfer pakietów pomiędzy stacjami.

3) Warstwa sieci. Oprogramowanie działające w tej warstwie udostępnia interfejs pomiędzy warstwą fizyczną i warstwą łącza danych a oprogramowaniem wyższych warstw, które odpowiada za nawiązanie i utrzymanie połączenia.

2) Warstwa łącza danych. Ta warstwa odpowiada za skuteczny transport informacji w warstwie fizycznej. Jej zadaniem jest synchronizacja bloków danych, rozpoznawanie błędów i sterowanie przepływem danych.

1) Warstwa fizyczna. Najbardziej podstawowa warstwa zaangażowana w transmisję strumienia danych poprzez fizyczne przewody. Sprzęt i oprogramowanie działające na tym poziomie obsługuje różne typy złączy, sygnalizację i schematy współużytkowania nośnika transmisyjnego.

Protokoly

Bodaj najwięcej fachowej terminologii dotyczy protokołów. Podobnie jak sygnały wymieniane w bejsbolu pomiędzy łapaczem i miotaczem, protokoły reprezentują porozumienie pomiędzy dwoma częściami sieci dotyczące sposobu przesłania danych. Chociaż ich nie widać i bardzo niewiele osób może powiedzieć, że je rozumie, ich wpływ na wydajność systemu jest imponujący. Słabo zaimplementowany protokół może spowolnić transfer danych, ale oprogramowanie zgodne ze standardowym protokołem umożliwia komunikację pomiędzy dwoma różnymi systemami. Na przykład protokół TCP/IP umożliwia transfer danych pomiędzy komputerami o różnych architekturach i systemach operacyjnych.

Kluczowe elementy protokołów to składnia, semantyka i synchronizacja. Składnia określa poziomy używanych sygnałów oraz formaty, w jakich przesyła się dane. Semantyka koncentruje się wokół struktury informacji wymaganej do koordynacji poszczególnych komputerów i do obsługi danych. Synchronizacja obejmuje dopasowanie prędkości oraz buforowanie (dzięki czemu komputer z połączeniem Ethernet 10 Mb/s może wymieniać dane z komputerem w sieci Fast Ethernet 100 Mb/s), a także ustawianie danych we właściwej kolejności (gdyby się pomieszały podczas transmisji).

Wszystkie te funkcje opisują protokoły. Ponieważ są one implementowane w rzeczywistych produktach, często nie są zupełnie zgodne z modelem OSI z powodu pewnych zaszłości historycznych albo dlatego, że twórcy produktu po prostu nie mogli się powstrzymać, aby nie dodać czegoś od siebie.

Lączenie segmentów sieci LAN

Ze względu na straty mocy ograniczona jest odległość, jaką mogą przebyć sygnały. W sieci Ethernet sygnał może zazwyczaj przebyć maksymalnie 300 m; w sieci Token-Ring najwyżej 180 m. Do przekazywania sygnałów na dalsze odległości – na przykład do innych sieci LAN lub do sieci rozległych – oraz do ich regeneracji w sieciach stosuje się wtórniki, mosty, routery i bramy.

Wtórniki (repeaters) funkcjonują adekwatnie do swojej nazwy; powtarzają sygnały pomiędzy sekcjami kabla sieciowego. W nowych sieciach dość trudno będzie spotkać te stosunkowo proste urządzenia. Wtórniki przekazują sygnały w obydwu kierunkach, nie stosując żadnej dyskryminacji. Wiele urządzeń, w rodzaju mostów i routerów, sprawdza dane przenoszone przez sygnał, aby stwierdzić, czy mają być one rzeczywiście przesłane do następnego segmentu.

Mosty (bridge) umożliwiają połączenie dwóch sieci lokalnych i pozwalają stacjom z jednej sieci na korzystanie z zasobów udostępnianych w drugiej sieci. Mosty używają protokołu sterowania dostępem do nośnika (Media Access Control – MAC) w warstwie fizycznej sieci. Mogą one łączyć nośniki różnego typu, na przykład światłowód z cienkim kablem koncentrycznym 802.3, o ile w obydwu przypadkach używany jest ten sam protokół warstwy MAC (na przykład Ethernet).

Routery działają w warstwie sieci modelu OSI. Router sprawdza adres każdej wiadomości i decyduje, czy adres ten odnosi się do lokalizacji poza mostem. Jeśli wiadomość nie musi być przesłana poprzez most i generować ruchu w leżącej za nim sieci, router nie przesyła jej. Routery są w stanie dokonywać translacji danych dla wielu różnych rodzajów okablowania i systemów sygnalizacji. Na przykład mogą przesyłać wiadomości z sieci Ethernet do sieci z komutacją pakietów poprzez modemy podłączone do szybkich, dzierżawionych linii telefonicznych.

Bramy (gateway), które działając w warstwie sesji, umożliwiają komunikację pomiędzy sieciami, w których używane są całkowicie różne protokoły. W sieciach komputerów PC bramy stanowią punkt połączenia z hostami, na przykład komputerami typu mainframe firmy IBM.

TCP/IP

Najwcześniejsze duże systemy sieciowe były budowane na potrzeby Departamentu Obrony USA. Departament ten finansował prace nad interaktywnym sieciowym oprogramowaniem komunikacyjnym dla wielu różnych systemów mainframe i minikomputerów. Jądro tych prac stanowiły programy implementujące dwa protokoły: Transmission Control Protocol (TCP) i Internet Protocol (IP). Dostępność oprogramowania wykorzystującego protokoły TCP/IP oraz potęga ich największego zastosowania, Internetu, sprawiają, że są one atrakcyjne dla menedżerów, którzy muszą stawić czoła wyzwaniom związanym z integracją odmiennych systemów komputerowych.

Rodzina protokołów TCP/IP jest szkieletem Internetu i korporacyjnych intranetów. Stała się ona wspólnym mianownikiem systemów komputerów na całym świecie.

NetBIOS

Innym instytucjonalnym rozwiązaniem, którego obsługa znacznie się rozpowszechniła, jest NetBIOS. NetBIOS zaczynał jako interfejs pomiędzy systemem IBM PC Network Program (PCNP, zastąpionym później przez system PC LAN) a kartami sieciowymi firmy Sytek. Projektując ten interfejs, zespół IBM/Sytek uczynił go jednocześnie programowalnym wejściem do sieci, które pozwoliło systemom sieciowym komunikować się na poziomie sprzętu sieciowego, bez potrzeby angażowania oprogramowania sieciowego.

„Oddolne” parcie użytkowników wielkich sieci wymusiło połączenie NetBIOS-u (działającego w warstwie sesji modelu OSI) i TCP/IP. W tej kombinacji programy użytkowe odwołują się do NetBIOS-u. Producenci tacy jak Novell nie używają protokołu NetBIOS w swoich kartach sieciowych, ale w swoje systemy operacyjne wbudowują emulatory NetBIOS-u, które oferują te same usługi komunikacyjne warstwy sesji co NetBIOS.

Moduły NetBIOS-u nawiązują ze sobą w sieci wirtualne sesje komunikacyjne. Jednak NetBIOS używa prostej konwencji nazewniczej, która nie sprawdza się dobrze w komunikacji pomiędzy sieciami lub w przypadku różnych systemów operacyjnych. Z pomocą przychodzi protokół IP z zestawu TCP/IP, który opakowuje dane NetBIOS-u, tak że mogą one bez przeszkód podróżować przez różne poziomy nazw i adresów sieci. Jednak z uwagi na rosnące znaczenie TCP/IP oraz promowanie przez Microsoft implementacji protokołu IPX Novella, NetBIOS odchodzi w przeszłość jako atrybut sieci wcześniejszych generacji.

SNA i APPC firmy IBM

Stary IBM chciał nas złapać w swoją Błękitną Pajęczynę, zwaną Systems Network Architecture (SNA). SNA przedstawia punkt widzenia IBM na to, jak powinny działać systemy komunikacyjne. Opisany wcześniej model OSI był próbą stworzenia struktury otwartej w odpowiedzi na zamkniętą architekturę SNA.

APPC (Advanced Program-to-Program Communications) to protokół w ramach modelu SNA ustalający warunki, które umożliwiają programom komunikowanie się ze sobą w sieci. Protokół APPC jest analogiem warstwy sesji w modelu OSI. Według IBM protokół APPC ma stać się podstawą komunikacyjną wszystkich przyszłych produktów i systemów korporacyjnych.

Dwa inne terminy ze słownika IBM – APPC/PC i LU 6.2 – to nazwy produktów, które są implementacją specyfikacji APPC. Programy te jednak są duże, nieporęczne i nie zdobyły popularności.

DECnet

Nie ma już Digital Equipment Corporation. Compaq Computer przejął ją w całości, ale w starszych instalacjach można jeszcze spotkać działające sieci Digitala. Firma ta opracowała własny stos protokołów do łączenia produkowanych przez siebie systemów, zarówno lokalnie, jak i w sieciach rozległych. System DECnet jest bardzo zawiły i wszelkie działające w nim instalacje mają przed sobą krótką przyszłość.

APPLE

Firma Apple Computer ma własne protokoły, składające się na rodzinę AppleTalk. Protokół AFP (AppleTalk Filling Protocol) na przykład, umożliwia współużytkowanie plików w sieci. W systemach operacyjnych komputerów Macintosh protokół AFP łączy się z systemem plików HFS (Hierarchical File System).

Rozproszczone systemy plików

SMB, RFS, NFS i XNS to skróty niektórych protokołów rozproszonych systemów plików. Rozproszone systemy plików pozwalają komputerowi w sieci korzystać

z plików i urządzeń peryferyjnych innego komputera w tej sieci, tak jakby to były zasoby dostępne lokalnie. Systemy operacyjne komputerów łączą się ze sobą, dzięki czemu katalog udostępniany na hoście jest widziany jako dysk lub jako osobny katalog na innym komputerze. W ten sposób programy użytkowe na komputerze danego użytkownika mają dostęp do plików i zasobów hosta bez żadnych dodatkowych programów.

Protokoły te działają w podobny sposób, jednak nie można ich stosować zamiennie. Zazwyczaj liczący się dostawca opracowuje protokół na potrzeby rodziny swoich produktów, a inni dostawcy wykupują licencję na ten protokół w celu zachowania zgodności swoich produktów.

Skrót SMB pochodzi od nazwy Server Message Block. Jest to protokół opracowany przez IBM i Microsoft na użytek programu PC LAN oraz sieci w systemie Windows. Produkty firm, takich jak AT&T, Digital, HP, Intel, Ungerman-Bass i innych obsługują ten protokół lub są z nim przynajmniej częściowo zgodne.

RFS to Remote File Service opracowany przez AT&T. Ponieważ protokół RFS był integralną częścią wielu wersji firmowej implementacji Uniksa AT&T, obsługiwały go również produkty innych dostawców z branży uniksowej. Protokół RFS wprowadził koncepcję strumieni efektywnych (powerful streams), która umożliwia aplikacjom otwieranie strumieni z lub do urządzenia (w Uniksie wszystko jest urządzeniem: port szeregowy, dysk, itp.) poprzez dowolnie zdefiniowany interfejs na poziomie transportu (Transport-Level Interface – TLI). TLI może być domyślną usługą transportową w Uniksie, może nią być również TCP lub inny protokół.

Z kolei NFS pochodzi od Network File System, architektury opracowanej przez Sun Microsystems. PC-NFS Suna jest kompletnym, choć bez żadnych dodatków, sieciowym systemem operacyjnym dla komputerów PC. Ten rezydujący w pamięci moduł umożliwia dostęp do plików, które są przechowywane w minikomputerach z systemem Unix.

Firmy z branży profesjonalnych stacji roboczych – w tym Harris Corporation, HP, Texas Instruments i inne – obsługują architekturę NFS w swoich produktach.

Powrót do strony glównej

Darmowy hosting zapewnia PRV.PL